The term user, within the context of the application domain, has always referred to the entity that interacts with an application. User acceptance testing was, at one time, one of the final stages of application development during which the people who would be interacting with the application sat down to determine whether it was acceptable and met their business requirements.

As technology has evolved, so too has the definition of user. This evolution can be attributed to the maturity of the Internet and the rapid increases in computing power. The observation that our smartphones hold more computing power than was used to reach the moon in 1969 is only amusing because it’s true. Advances in hardware design have led to the ability to cram incredible amounts of compute power into very small components.

Just as shifts in application architectures drive changes in the technologies that deliver and secure them, shifts in the definition of user have driven changes in where applications are deployed.

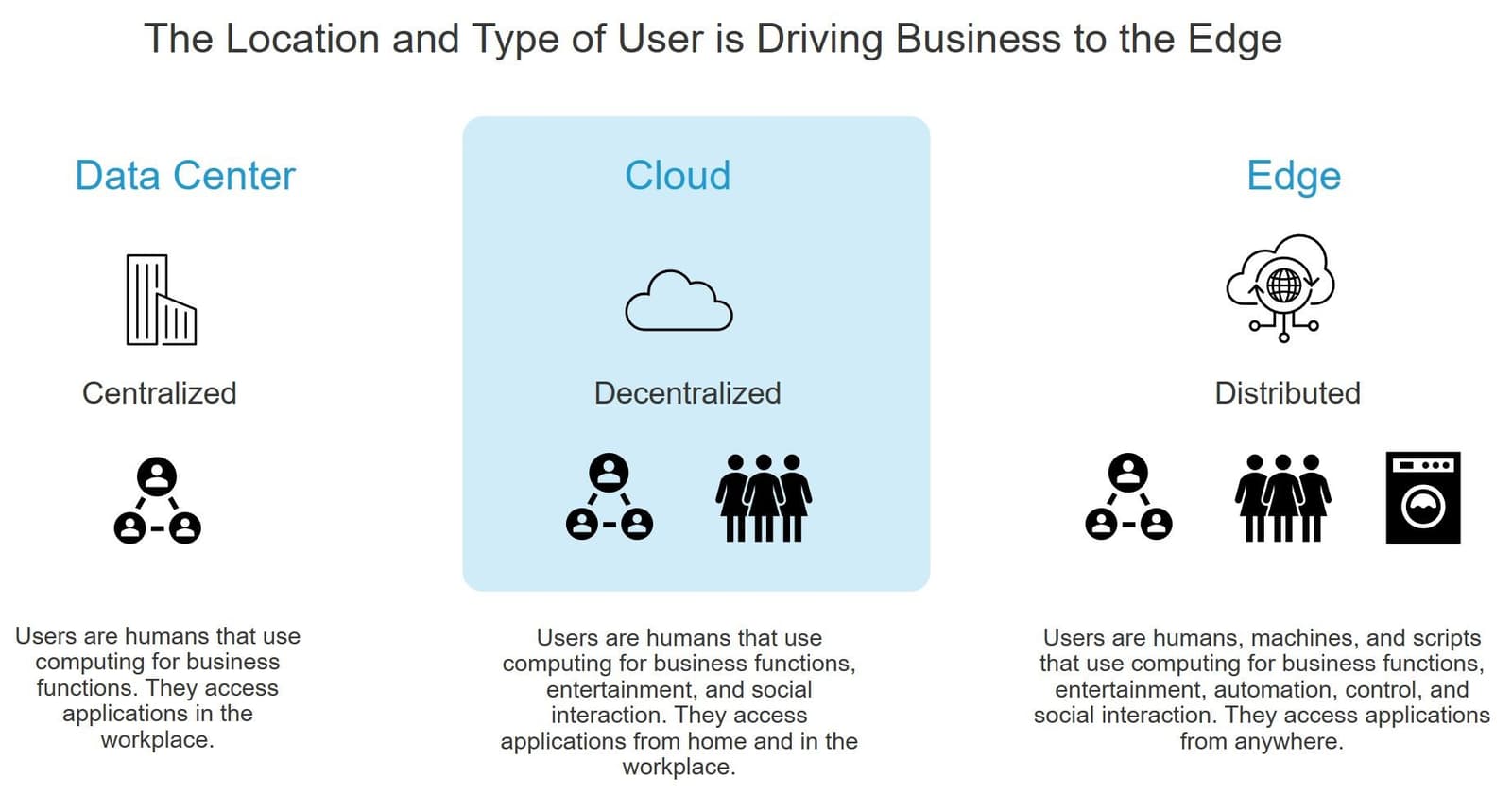

In the Data Center era, users were almost exclusively human beings who accessed applications in the workplace. Hence, data centers were nearly always collocated with the business they supported.

During the Cloud era, the Internet enabled a new operational model—public cloud—to better serve a new category of users who accessed applications from home. Applications needed to be more broadly and easily accessible from multiple locations because users were now accessing them from multiple locations.

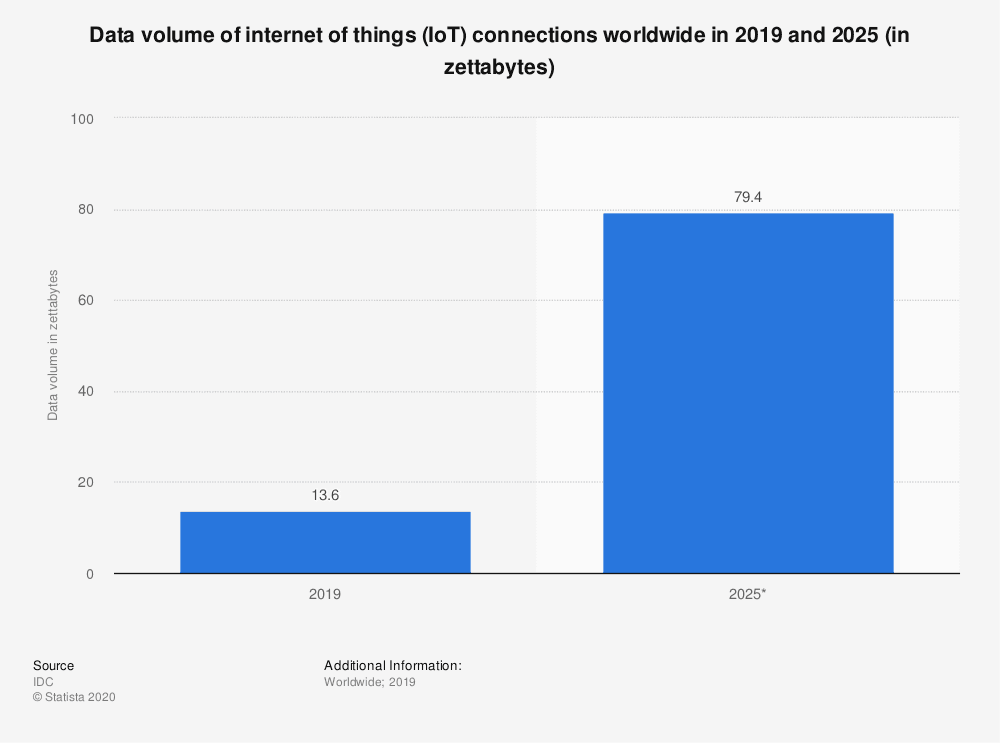

Today, new categories of users are being added that span software, machines, devices, and sensors in addition to human beings. These users access applications from anywhere and everywhere. As of November 2020, in the US alone, 45.38% of web traffic originated from mobile phones. The average American boasts more than ten different connected devices. Televisions, appliances, and even our light bulbs are using applications via the Internet.

This change in definition and distribution of users is a significant driving force behind edge computing.

Consider Cisco’s Annual Internet Report analysis and forecast that predicts that "by 2023, there will be more than three times more networked devices on Earth than humans. About half of the global connections will be machine-to-machine connections and the M2M space will be dominated by consumer-oriented 'things' in smart homes and automobiles." (RCRWireless News)

Business has always sought to provide applications that meet users where they are. Business now needs to meet users of all kinds at the edges of the Internet. The applications that enable humans and machines to conduct business and execute designated tasks need to be closer to the users that interact with them.

One of the top reasons for this is the universal need for speed. Whether it’s a need for application performance or for a rapid response to instruct a device, speed is something both humans and machines look to edge computing to provide.

To wit, two of the top three use cases for edge according to respondents in our annual research are:

- Improving application performance (43%)

- Real time computing/processing/analysis requiring less than 20ms latency (34%)

From this, one can infer that existing speeds are not fast enough. One reason is the composition of applications, which today incurs a great deal of latency. With myriad components, each requiring time to look up and retrieve, it’s no surprise that application performance continues to plague brands and users alike even as network speed and capacity have steadily increased.

And though compute power has dramatically increased over time, the network continues to determine just how fast we can move data across the network. With multiple human users and even more machine and system users per household, increasing available bandwidth isn’t solving the equation needed to achieve better performance. In many cases, it’s simply not possible to increase bandwidth and network speeds due to the laws of physics and economics.

Moving applications—particularly those that process and analyze data—closer, then, is one solution business can leverage because application location is the most flexible variable in the performance equation.

We are moving into an era in which applications must be as mobile as their users. An era in which data centers and public cloud have a role, but not as the "final destination" for deployment. Instead, enterprise and cloud data centers will serve as sources of compute, network, and storage that can be made part of a larger, more flexible mesh of resources that spans locations across which applications can move fluidly and on demand.

That era is the edge era, and we believe the platform that will enable it is Edge 2.0.

About the Author

Related Blog Posts

Multicloud chaos ends at the Equinix Edge with F5 Distributed Cloud CE

Simplify multicloud security with Equinix and F5 Distributed Cloud CE. Centralize your perimeter, reduce costs, and enhance performance with edge-driven WAAP.

At the Intersection of Operational Data and Generative AI

Help your organization understand the impact of generative AI (GenAI) on its operational data practices, and learn how to better align GenAI technology adoption timelines with existing budgets, practices, and cultures.

Using AI for IT Automation Security

Learn how artificial intelligence and machine learning aid in mitigating cybersecurity threats to your IT automation processes.

Most Exciting Tech Trend in 2022: IT/OT Convergence

The line between operation and digital systems continues to blur as homes and businesses increase their reliance on connected devices, accelerating the convergence of IT and OT. While this trend of integration brings excitement, it also presents its own challenges and concerns to be considered.

Adaptive Applications are Data-Driven

There's a big difference between knowing something's wrong and knowing what to do about it. Only after monitoring the right elements can we discern the health of a user experience, deriving from the analysis of those measurements the relationships and patterns that can be inferred. Ultimately, the automation that will give rise to truly adaptive applications is based on measurements and our understanding of them.

Inserting App Services into Shifting App Architectures

Application architectures have evolved several times since the early days of computing, and it is no longer optimal to rely solely on a single, known data path to insert application services. Furthermore, because many of the emerging data paths are not as suitable for a proxy-based platform, we must look to the other potential points of insertion possible to scale and secure modern applications.