Leveraging containers enables you to develop cloud-native apps with a “write once, run anywhere” methodology. That doesn’t happen in a vacuum, though. Containerized applications need native application delivery mechanisms to deliver optimal performance. Sticking with the traditionally static, IT-managed configuration is at odds with the agility you need to keep up with the spinning up and down of microservices containers that can happen on a minute-by-minute basis.

When you employ a micro-services-based solution, you need app security and performance solutions that are aligned with that dynamic architecture. You should be able to manage your app services as code and integrate them into the CI/CD workflow. You need reliable application delivery services integrated with the container platform management plane.

F5 NGINX application delivery services are designed and optimized for container environments, making it an ideal choice when leveraging container platforms such as Kubernetes and Red Hat OpenShift. Plus, standardizing on NGINX for both container and non-container environments reduces complexity and ensures greater consistency and reliability.

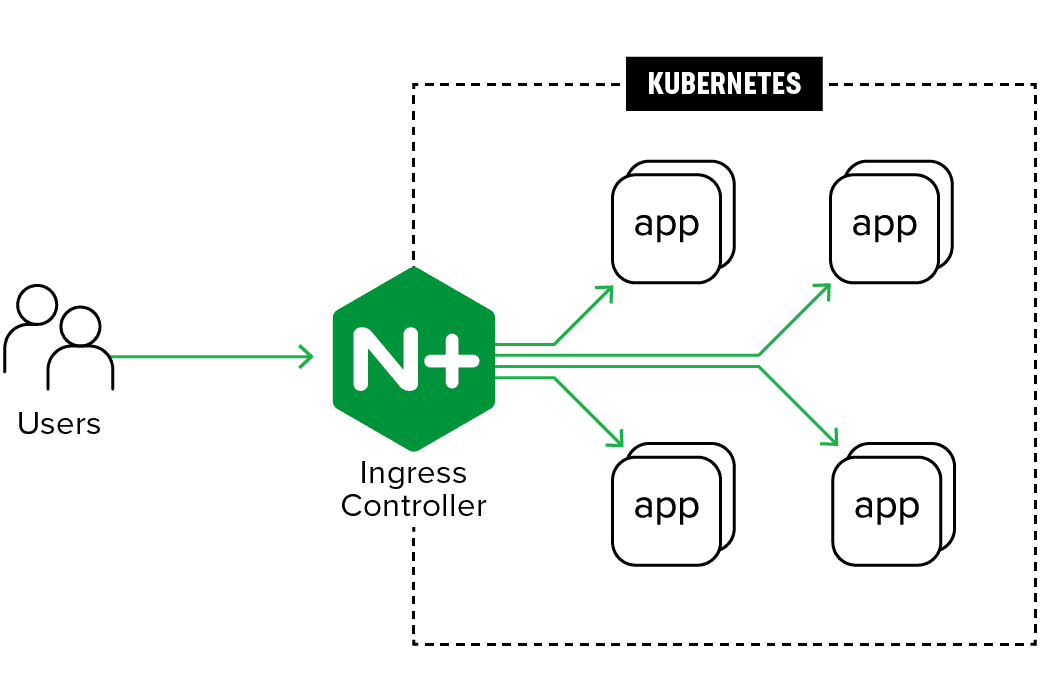

As the top ingress controller for Kubernetes1, NGINX Ingress Controller provides automated configuration for NGINX load balancers to ensure that applications in Kubernetes clusters are delivered reliably and securely without compromising performance.

As the top ingress controller for Kubernetes1, NGINX Ingress Controller provides automated configuration for NGINX load balancers to ensure that applications in Kubernetes clusters are delivered reliably and securely without compromising performance.

In the architecture above, we demonstrate how NGINX Ingress Controller provides enterprise-grade application delivery services for containerized apps.

Organizations use container platforms such as Kubernetes or RedHat OpenShift in combination with agile development methodologies to speed up application development and deployment.

Containers are foundational infrastructure components for developing cloud-native applications as they enable flexibility and portability that allow developers to “write once, run anywhere.” Containers reduce dependencies and allow component-level scaling, which is key to modernizing applications using microservices.

Your containerized apps need native application delivery mechanisms to deliver optimal performance. Developers and DevOps teams need a cloud-agnostic lightweight application delivery solution for Kubernetes and OpenShift environments.

But a traditional approach with a static configuration changed only by IT conflicts with the agile container paradigm where new microservice containers might be created dynamically for just a few minutes to service a spike in demand or roll out an upgrade by simply replacing old containers with new ones.

How do you ensure that your app services deployments keep up with your rapid release cycles in containerized environments? Download the solution guide to get all the details.

You need reliable application delivery services integrated with the container platform management plane. You can best support your containerized apps with NGINX, the most widely pulled and starred application on DockerHub, with more than 1 billion downloads.

And with 64% of the market, NGINX is also by far the most popular Kubernetes Ingress Controller, according to the Cloud Native Computing Foundation. NGINX also supports Red Hat OpenShift environments, a container application platform built on top of Kubernetes.

To deliver consistent and powerful multi-cloud application services in containerized environments, leverage the following NGINX components.

No matter where they run, applications can benefit from the performance that NGINX offers.

With solutions designed for Kubernetes and OpenShift environments, applications running in dynamic container platforms can get the services they need configured on demand—by tools native to the container management system.

Read more about the future of the NGINX Application Platform and how F5 is helping businesses evolve their apps for the digital age.

FOOTNOTE

Watch this webinar to learn about the latest developments in NGINX Ingress Controller Release 1.5.0.

LKQD Technologies Reduces Operational Complexity with NGINX Ingress Controller.

Find the best microservices design strategies and learn how to begin refactoring monolithic applications into microservices.

It's not a good idea to typecast containers into a narrow role that involves only microservices, because they are able to do much more.

Containerized applications need an application delivery infrastructure designed for containers.