- Today’s fast-paced, digitally-enabled data centers need to be able to direct traffic, not just distribute it.

- Red Hat OpenShift is in use by 21% of respondents according to the State of Application Delivery 2018.

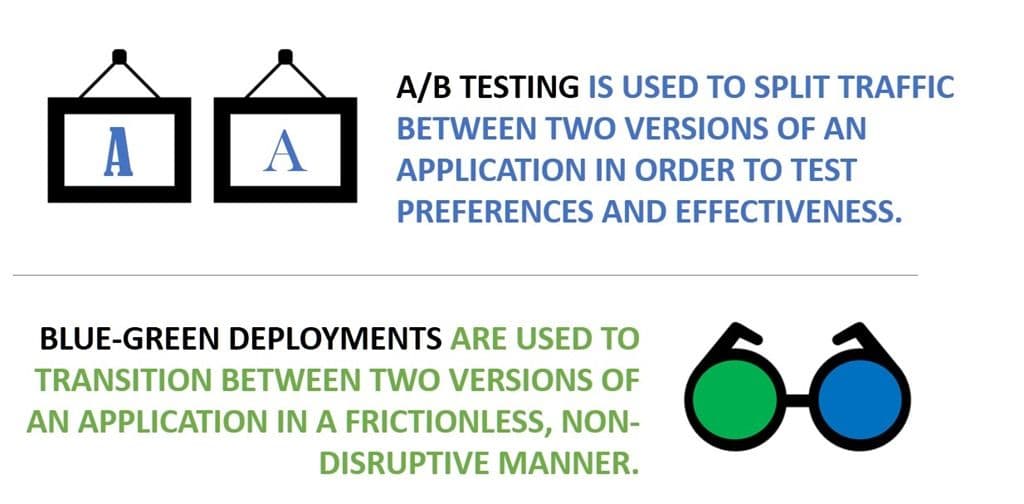

- A/B Testing and Blue/Green Deployments are beneficial deployment patterns that assist in meeting business and operational goals by intelligently directing requests.

- F5 Container Connector facilitates real-time control plane integration of BIG-IP with container orchestration environments that enables A/B testing and Blue/Green deployments with Red Hat OpenShift.

- Because Red Hat OpenShift has a native Kubernetes distribution, the F5 integration for OpenShift utilizes the same controller as the F5 Integration for Kubernetes (

k8s-bigip-ctlr) which is available on Dockerhub or Github.

For too long, the role of a load balancing proxy has been simply to make sure every request got a speedy response. Plain Old Load Balancing (POLB). POLB uses algorithms to distribute requests across a pool of resources. Round robin. Least connections. Fastest Response. The focus of these algorithms is always on the destination; on selecting a resource that is available and fast to provide a response and get it on its way back to an impatient user. The goal is availability, and POLB certainly meets that expectation.

Now, that’s useful, but scaling modern applications is more than just about selecting the right algorithm – it’s about enabling architectures. Scaling modern applications – particularly those deployed in container environments – requires the ability to not just distribute but direct requests. The goal is to realize efficiency and agility of both the infrastructure and the business, and that’s something POLB can’t realize. We have to go beyond POLB if we want to support modern deployment patterns like A/B testing and Blue/Green Deployments that helps operations move as fast as the business needs to.

That requires a smart proxy that can not only distribute requests but direct them based on a variety of information available from the client, the network, and the environment in which they are operating. An L7 proxy, if you prefer. Whatever we call it, it’s smart enough to be able to parse and understand a request from top (HTTP) to bottom (IP) and be able to make decisions as to where to direct a request.

In this post, we’re spotlighting the ability to easily configure and implement A/B testing and Blue/Green deployment patterns, both of which require some smarts at the proxy in order to intelligently direct requests to the appropriate resources.

In containerized environments, this requires the ability to integrate with the container orchestration environment (COE) as well as intelligently direct traffic.

That’s what F5 Container Connector for Red Hat OpenShift provides today. It’s the containerized ‘glue’ between OpenShift and F5 BIG-IP that enables us to intelligently shift traffic from one version of an application to another (blue-green) or enable a comparison-based test between two versions of the same app so the business can make a decision based on data from real visitors.

You can read more about the details on both in the documentation, or grab your own copy of our F5 Container Connector on Dockerhub or Github and get started with these advanced deployments today.

About the Author

Related Blog Posts

Why sub-optimal application delivery architecture costs more than you think

Discover the hidden performance, security, and operational costs of sub‑optimal application delivery—and how modern architectures address them.

Keyfactor + F5: Integrating digital trust in the F5 platform

By integrating digital trust solutions into F5 ADSP, Keyfactor and F5 redefine how organizations protect and deliver digital services at enterprise scale.

Architecting for AI: Secure, scalable, multicloud

Operationalize AI-era multicloud with F5 and Equinix. Explore scalable solutions for secure data flows, uniform policies, and governance across dynamic cloud environments.

Nutanix and F5 expand successful partnership to Kubernetes

Nutanix and F5 have a shared vision of simplifying IT management. The two are joining forces for a Kubernetes service that is backed by F5 NGINX Plus.

AppViewX + F5: Automating and orchestrating app delivery

As an F5 ADSP Select partner, AppViewX works with F5 to deliver a centralized orchestration solution to manage app services across distributed environments.

F5 NGINX Gateway Fabric is a certified solution for Red Hat OpenShift

F5 collaborates with Red Hat to deliver a solution that combines the high-performance app delivery of F5 NGINX with Red Hat OpenShift’s enterprise Kubernetes capabilities.